随着大数据时代的到来,数据已成为企业和社会发展的核心资产。海量数据的涌现也带来了治理难题。从技术视角来看,大数据治理的核心在于数据处理,它涉及数据的采集、存储、清洗、整合与分析等多个环节。有效的治理能够确保数据的质量、安全与合规性,从而最大化数据的价值。

数据采集是大数据治理的起点。现代技术如物联网传感器、日志收集工具和API接口等,使得企业能够实时获取多样化的数据源。采集过程中需注意数据的完整性和准确性,避免引入噪声或偏差。例如,在金融行业,通过实时监控交易数据,可以快速检测欺诈行为,但若数据源不可靠,可能导致误判。因此,采用标准化协议和验证机制是技术实现的关键。

数据存储与清洗是确保数据可用性的基础。大数据通常存储在分布式系统如Hadoop或云平台中,这些技术提供了高可扩展性和容错能力。但原始数据往往包含冗余、不一致或缺失值,需通过ETL(提取、转换、加载)流程进行清洗。技术工具如Apache Spark或Talend能够自动化处理数据转换,提升数据质量。例如,在电商平台,清洗用户行为数据后,可以更精准地推荐产品,从而提高用户体验。

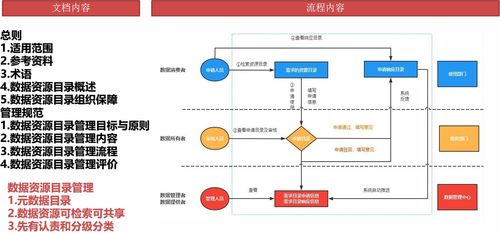

接着,数据整合与治理框架的构建是技术视角下的核心挑战。大数据常来自异构源,如结构化数据库和非结构化社交媒体数据,整合时需要统一数据模型和元数据管理。技术解决方案包括数据湖架构和主数据管理(MDM)系统,它们帮助实现数据的一致性和可追溯性。治理工具如Collibra或Apache Atlas提供数据血缘追踪和策略执行,确保数据生命周期中的合规性。以医疗行业为例,整合患者记录和科研数据时,必须遵守隐私法规如HIPAA,这要求技术在加密和访问控制上做到精细管理。

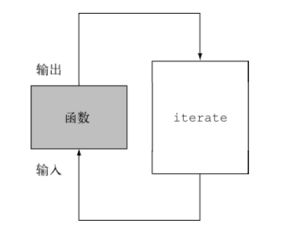

数据分析与应用是数据治理的最终目标。通过机器学习算法和可视化工具,企业可以从数据中挖掘洞察,驱动决策。但技术实现需平衡性能与成本,例如使用实时流处理技术如Apache Kafka应对高并发场景。数据治理还需关注伦理问题,如算法偏见,这要求技术设计融入公平性检查。

从技术视角看,大数据治理的数据处理环节是一个系统工程,涉及采集、存储、清洗、整合和分析等多个层面。通过采用先进工具和框架,企业可以构建高效、安全的治理体系,释放数据潜力。随着人工智能和边缘计算的发展,大数据治理技术将更智能化,助力各行各业实现数字化转型。